NVIDIA ha revelado una innovación clave para la inferencia de modelos de lenguaje a gran escala: Helix Parallelism, una estrategia de paralelización diseñada para manejar contextos de millones de tokens en tiempo real. Esta tecnología permite a los modelos mantener coherencia y relevancia en tareas como asistentes virtuales, análisis legal o programación, sin sacrificar velocidad ni escalabilidad.

Desafíos de la inferencia con contextos largos

Los modelos modernos enfrentan dos cuellos de botella principales durante la generación:

- Lectura del KV cache: cada GPU debe acceder a un historial masivo de tokens previos, saturando el ancho de banda de la memoria

- Carga de pesos FFN: cada nuevo token requiere cargar grandes pesos de red neuronal, lo que genera latencia en escenarios de baja concurrencia

¿Qué es Helix Parallelism?

Helix es una estrategia híbrida que separa la paralelización de la atención y las redes FFN en una tubería temporal, optimizando cada etapa según su cuello de botella. Inspirado en la estructura del ADN, Helix entrelaza:

- KV Parallelism (KVP): divide el KV cache entre GPUs

- Tensor Parallelism (TP): distribuye los pesos FFN

- Expert Parallelism (EP): en modelos tipo MoE, permite mayor eficiencia

Ejecución eficiente y reutilización de GPUs

Helix reutiliza el mismo grupo de GPUs para cada fase del modelo, evitando tiempos muertos. Además, introduce HOP-B (Helix Overlap Pipeline-Batch-wise), una técnica que solapa comunicación y cómputo entre lotes, reduciendo aún más la latencia entre tokens.

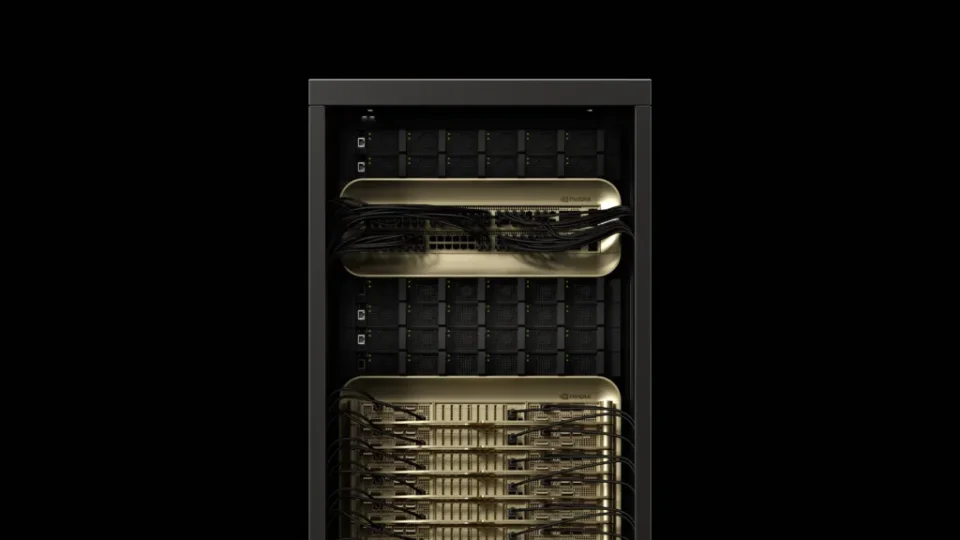

Resultados en hardware Blackwell

Simulaciones con el modelo DeepSeek-R1 671B y contextos de 1 millón de tokens muestran que Helix:

- Aumenta hasta 32 veces el número de usuarios concurrentes a latencia fija

- Reduce la latencia entre tokens hasta 1,5 veces en escenarios de baja concurrencia

- Optimiza el uso de memoria y ancho de banda al evitar duplicación de KV cache

Helix Parallelism representa un avance crucial para la inferencia de modelos con contextos ultra largos. Al combinar paralelización inteligente con hardware como NVIDIA Blackwell y precisión FP4, permite experiencias de IA más rápidas, escalables y contextualmente ricas.

El artículo puede contener imprecisiones y/o errores, consulte la web del fabricante para obtener la principal información.