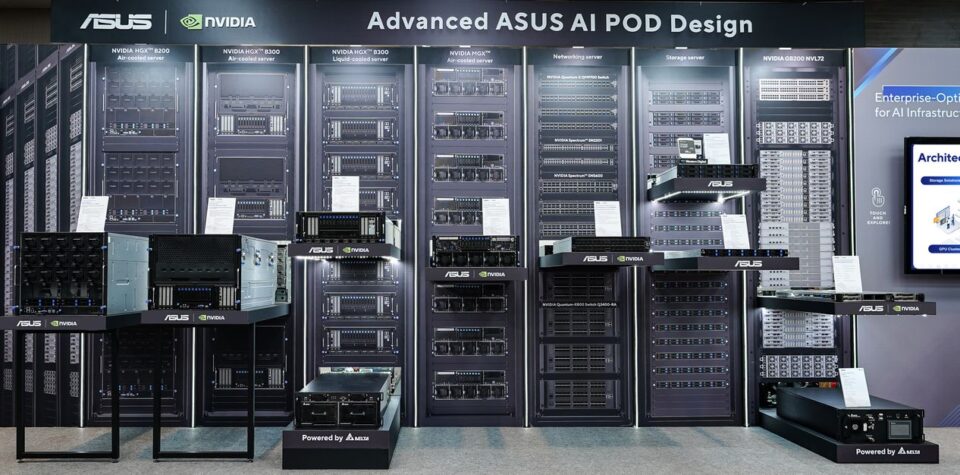

En el marco de Computex 2025, ASUS ha anunciado un avance significativo en infraestructura de inteligencia artificial (IA) al presentar su nuevo diseño de AI POD, desarrollado en colaboración con NVIDIA. Este diseño validado por la Enterprise AI Factory de NVIDIA está optimizado para acelerar la adopción de IA en las empresas, ofreciendo soluciones escalables y eficientes para cargas de trabajo complejas.

Arquitectura de alto rendimiento para IA

El diseño de AI POD de ASUS incorpora racks de alta densidad, compatibles con sistemas de refrigeración líquida o por aire, y equipados con las plataformas NVIDIA GB200/300 NVL72. Estas configuraciones permiten escalar eficientemente las operaciones de IA, soportando hasta 576 GPUs en ocho racks con refrigeración líquida, o 72 GPUs en un solo rack con refrigeración por aire. La integración de redes NVIDIA Quantum InfiniBand o Spectrum-X Ethernet garantiza una conectividad de alta velocidad y baja latencia, esencial para aplicaciones de IA de gran escala.

Flexibilidad en el diseño

ASUS ha adoptado arquitecturas flexibles basadas en los diseños NVIDIA MGX y HGX, incorporando procesadores Intel Xeon 6 y SuperNICs NVIDIA ConnectX-8. Esta combinación permite manejar cargas de trabajo avanzadas de IA y renderizado 3D complejo, ofreciendo soluciones adaptables a diversas necesidades empresariales.

«El diseño validado de la Enterprise AI Factory de NVIDIA con el AI POD de ASUS proporciona orientación para desarrollar, implementar y gestionar cargas de trabajo de IA agentica, IA física y HPC en la plataforma Blackwell de NVIDIA en instalaciones locales», destaca el comunicado de prensa.

Ecosistema completo para IA

El AI POD de ASUS no solo se centra en el hardware, sino que también ofrece un ecosistema completo para la implementación de IA. Esto incluye integración con NVIDIA Omniverse, almacenamiento de alta velocidad y soporte para IA agentica en tiempo real. Estas características permiten a las empresas desplegar soluciones de IA de manera eficiente y con menor riesgo, acelerando el tiempo de obtención de valor.

Preparado para cargas de trabajo intensivas

Los racks compatibles con NVIDIA MGX de ASUS, como la serie ESC8000, están diseñados para manejar modelos de lenguaje de gran tamaño (LLMs) y cargas de trabajo inmersivas. Equipados con procesadores Intel Xeon 6 y GPUs RTX PRO 6000 Blackwell Server Edition, estos sistemas ofrecen un rendimiento excepcional y escalabilidad para las demandas actuales de IA.

Además, las arquitecturas de referencia NVIDIA HGX optimizadas por ASUS proporcionan eficiencia térmica y densidad de GPU sin precedentes, ideales para el ajuste fino de IA, inferencia de LLM y entrenamiento. Estas soluciones están disponibles en configuraciones con refrigeración líquida o por aire, asegurando un rendimiento consistente y reducción del costo total de propiedad.

Infraestructura para la IA del futuro

El compromiso de ASUS con la innovación en IA se refleja en su enfoque en la IA agentica, que permite decisiones autónomas y aprendizaje en tiempo real. La infraestructura de ASUS está diseñada para soportar agentes de IA escalables en aplicaciones empresariales, facilitando la transformación digital en diversas industrias.

«Como líder global en soluciones de infraestructura de IA, ASUS proporciona excelencia en centros de datos con opciones de refrigeración por aire y líquida, ofreciendo un rendimiento, eficiencia y confiabilidad incomparables», señala el comunicado.

La colaboración entre ASUS y NVIDIA en el desarrollo del diseño avanzado de AI POD representa un paso importante hacia la implementación efectiva de soluciones de IA en el entorno empresarial. Con arquitecturas flexibles, un ecosistema completo y preparación para cargas de trabajo intensivas, estas soluciones están diseñadas para satisfacer las crecientes demandas de la inteligencia artificial en el mundo actual.

El artículo puede contener imprecisiones y/o errores, consulte la web del fabricante para obtener la principal información