NVIDIA ha establecido un nuevo estándar en el entrenamiento de modelos de inteligencia artificial con su arquitectura Blackwell. En la última ronda de MLPerf Training v5.0, la plataforma de IA de NVIDIA logró el mayor rendimiento a escala en todos los benchmarks, incluyendo el exigente preentrenamiento del modelo Llama 3.1 405B.

Resultados Destacados en MLPerf Training v5.0

La arquitectura Blackwell de NVIDIA fue la única en presentar resultados en todos los benchmarks de MLPerf Training v5.0, demostrando su versatilidad y alto rendimiento en diversas cargas de trabajo de IA, como modelos de lenguaje de gran escala (LLMs), sistemas de recomendación, LLMs multimodales, detección de objetos y redes neuronales gráficas.

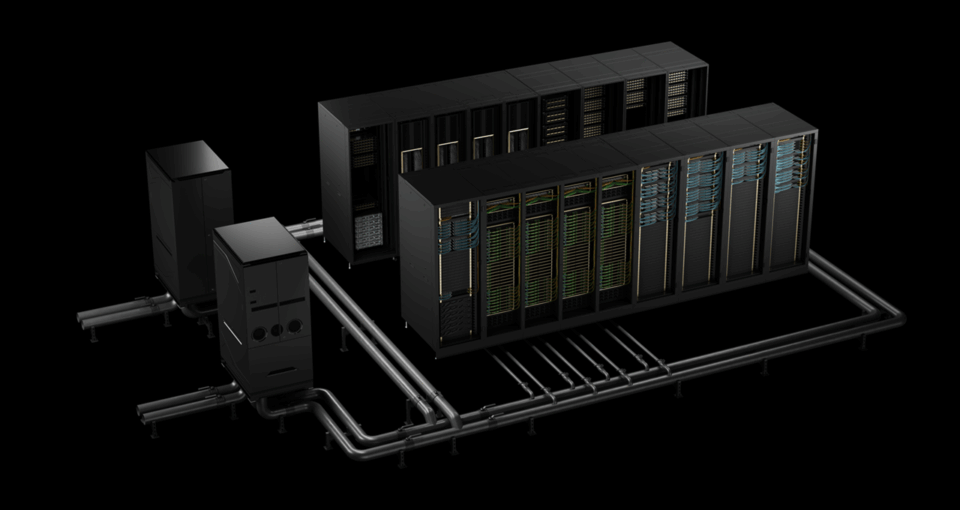

Supercomputadoras Tyche y Nyx

Las presentaciones a gran escala utilizaron dos supercomputadoras de IA impulsadas por la plataforma Blackwell: Tyche, construida con sistemas NVIDIA GB200 NVL72 a escala de rack, y Nyx, basada en sistemas NVIDIA DGX B200. Además, NVIDIA colaboró con CoreWeave e IBM para presentar resultados utilizando un total de 2,496 GPUs Blackwell y 1,248 CPUs NVIDIA Grace.

Mejoras de Rendimiento Significativas

En el nuevo benchmark de preentrenamiento de Llama 3.1 405B, Blackwell ofreció un rendimiento 2.2 veces superior en comparación con la arquitectura de generación anterior a la misma escala. En el benchmark de ajuste fino de Llama 2 70B LoRA, los sistemas NVIDIA DGX B200, con ocho GPUs Blackwell, lograron un rendimiento 2.5 veces mayor en comparación con una presentación utilizando la misma cantidad de GPUs en la ronda anterior.

Innovaciones Tecnológicas

Estas mejoras de rendimiento destacan los avances en la arquitectura Blackwell, incluyendo racks de alta densidad con refrigeración líquida, 13.4TB de memoria coherente por rack, tecnologías de interconexión de quinta generación NVIDIA NVLink y NVIDIA NVLink Switch para escalado vertical, y redes NVIDIA Quantum-2 InfiniBand para escalado horizontal. Además, las innovaciones en la pila de software, como el marco NVIDIA NeMo, elevan el estándar para el entrenamiento de LLMs multimodales de próxima generación, fundamentales para llevar al mercado aplicaciones de IA agentes.

Colaboraciones Estratégicas

El ecosistema de socios de NVIDIA participó extensamente en esta ronda de MLPerf. Además de la colaboración con CoreWeave e IBM, se presentaron contribuciones destacadas de empresas como ASUS, Cisco, Dell Technologies, Giga Computing, Google Cloud, Hewlett Packard Enterprise, Lambda, Lenovo, Nebius, Oracle Cloud Infrastructure, Quanta Cloud Technology y Supermicro.

Impacto en la Industria de la IA

La plataforma de centro de datos de NVIDIA incluye GPUs, CPUs, tejidos y redes de alta velocidad, así como una amplia gama de software como las bibliotecas CUDA-X, el marco NeMo, NVIDIA TensorRT-LLM y NVIDIA Dynamo. Este conjunto altamente optimizado de tecnologías de hardware y software permite a las organizaciones entrenar y desplegar modelos más rápidamente, acelerando drásticamente el tiempo hasta obtener valor.

La arquitectura Blackwell de NVIDIA ha demostrado ser un avance significativo en el entrenamiento de modelos de inteligencia artificial, estableciendo nuevos récords de rendimiento y eficiencia en los benchmarks de MLPerf Training v5.0. Con sus innovaciones tecnológicas y colaboraciones estratégicas, NVIDIA continúa liderando el camino en la evolución de la IA a gran escala.

El artículo puede contener imprecisiones y/o errores, consulte la web del fabricante para obtener la principal información.