Una nueva era para la IA en el escritorio

El 29 de mayo de 2025, NVIDIA anunció la integración de AnythingLLM con sus microservicios NIM y GPUs RTX, ofreciendo a los entusiastas de la inteligencia artificial una solución potente y accesible para ejecutar modelos de lenguaje de gran tamaño (LLMs) directamente en sus PCs. Esta combinación permite a los usuarios disfrutar de una experiencia de IA local optimizada, sin depender de servicios en la nube y manteniendo la privacidad de sus datos.

¿Qué es AnythingLLM?

AnythingLLM es una aplicación de escritorio de código abierto diseñada para facilitar el uso de LLMs en entornos locales. Ofrece una interfaz intuitiva que permite a los usuarios interactuar con modelos de lenguaje, realizar consultas sobre sus propios datos y ejecutar tareas complejas sin necesidad de configuraciones complicadas. Entre sus funcionalidades destacan:

- Respuesta a preguntas: Obtener respuestas precisas utilizando modelos como Llama y DeepSeek R1 sin incurrir en costos adicionales.

- Consultas sobre datos personales: Utilizar sistemas de recuperación aumentada (RAG) para consultar contenido privado, incluyendo archivos PDF, documentos de Word y bases de código.

- Resumen de documentos: Generar resúmenes de textos extensos, como artículos de investigación.

- Análisis de datos: Extraer información relevante al cargar archivos y consultarlos con LLMs.

- Acciones agenticas: Realizar investigaciones dinámicas utilizando recursos locales o remotos, ejecutando herramientas generativas y acciones basadas en las indicaciones del usuario.

Además, AnythingLLM se integra con una amplia variedad de modelos de código abierto y servicios en la nube, incluyendo OpenAI, Microsoft y Anthropic, proporcionando una experiencia versátil y adaptable a las necesidades de cada usuario.

Rendimiento optimizado con GPUs NVIDIA RTX

La combinación de AnythingLLM con GPUs GeForce RTX y NVIDIA RTX PRO ofrece mejoras significativas en el rendimiento al ejecutar LLMs y agentes. Gracias a los Tensores Cores de quinta generación, diseñados específicamente para acelerar tareas de inteligencia artificial, los usuarios experimentan una inferencia más rápida y eficiente.

AnythingLLM utiliza herramientas como Ollama, Llama.cpp y bibliotecas tensoriales GGML para la ejecución en el dispositivo, todas ellas optimizadas para GPUs RTX. Por ejemplo, en pruebas realizadas con la GeForce RTX 5090, se observó un rendimiento 2.4 veces superior en la inferencia de modelos como Llama 3.1 8B y DeepSeek R1 8B en comparación con el Apple M3 Ultra.

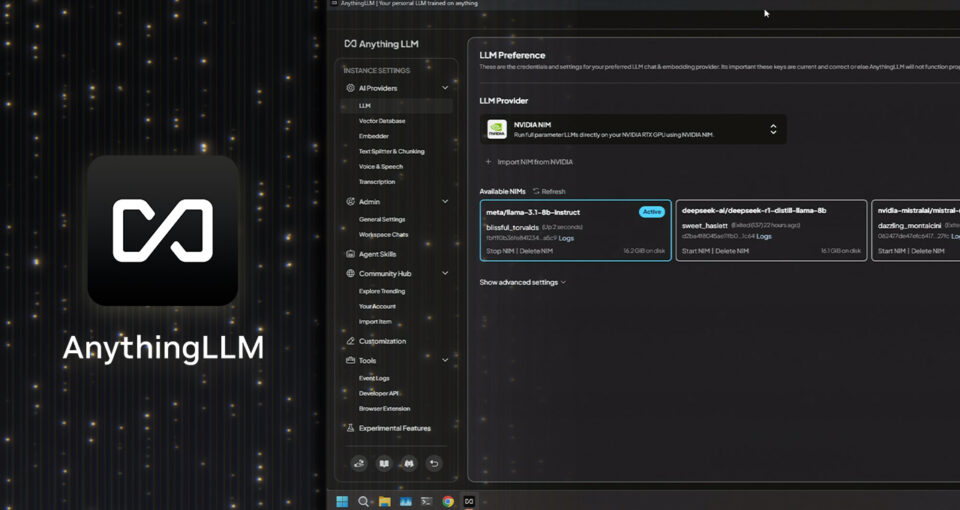

Integración con microservicios NVIDIA NIM

La reciente incorporación de soporte para los microservicios NVIDIA NIM en AnythingLLM simplifica aún más la implementación de modelos de IA generativa. Estos microservicios preempaquetados y optimizados ofrecen una forma rápida y sencilla de iniciar flujos de trabajo de IA en PCs con RTX, mediante una API simplificada.

Los NIMs son ideales para desarrolladores que buscan probar modelos de IA generativa en sus flujos de trabajo sin la necesidad de descargar múltiples archivos o configurar conexiones complejas. Al estar disponibles tanto en la nube como en PCs locales, facilitan la creación de prototipos y su posterior despliegue en entornos de producción.

Al integrarlos en la interfaz amigable de AnythingLLM, los usuarios pueden experimentar con ellos de manera rápida y eficiente, conectándolos a sus flujos de trabajo o aprovechando los AI Blueprints de NVIDIA, junto con documentación y ejemplos de código, para integrarlos directamente en sus aplicaciones o proyectos.

Privacidad y control total

Una de las principales ventajas de utilizar AnythingLLM con GPUs RTX y microservicios NIM es la capacidad de ejecutar modelos de IA de forma totalmente local, manteniendo la privacidad de los datos del usuario. Al no depender de servicios en la nube, se elimina la necesidad de enviar información sensible a servidores externos, ofreciendo un control total sobre los datos y garantizando la confidencialidad de la información procesada.

Además, la ejecución local permite a los usuarios aprovechar al máximo el hardware de sus PCs, obteniendo tiempos de respuesta más rápidos y una experiencia de usuario más fluida.

Facilidad de uso y accesibilidad

AnythingLLM está diseñado pensando en la accesibilidad, ofreciendo una instalación con un solo clic y la posibilidad de ejecutarse como una aplicación independiente o como una extensión del navegador. Su interfaz intuitiva elimina la necesidad de configuraciones complejas, permitiendo a los usuarios centrarse en sus tareas sin preocuparse por aspectos técnicos.

Como destaca NVIDIA: “AnythingLLM es una excelente opción para los entusiastas de la IA, especialmente aquellos con sistemas equipados con GPUs GeForce RTX y NVIDIA RTX PRO”.

Un ecosistema en constante evolución

Con la continua expansión de los microservicios NIM y la incorporación de nuevos flujos de trabajo de referencia, como la creciente biblioteca de AI Blueprints de NVIDIA, herramientas como AnythingLLM seguirán desbloqueando casos de uso multimodales de IA. Esto incluye generación de lenguaje e imágenes, visión por computadora y procesamiento de voz, entre otros.

La combinación de AnythingLLM con la potencia de las GPUs RTX y los microservicios NIM representa un paso significativo hacia la democratización de la inteligencia artificial, permitiendo a más usuarios acceder a herramientas avanzadas de IA directamente desde sus PCs.

El artículo puede contener imprecisiones y/o errores, consulte la web del fabricante para obtener la principal información.